9 ошибок при раскрутке нового сайта

Глобальной стартовой ошибкой раскрутки нового сайта, как правило, является отсутствие системного подхода. Надо с самого начала не наделать много ошибок, чтобы не попасть под фильтры поисковых систем. Иначе будет испорчена карма сайта, то есть репутация сайта у поисковиков. Исправить потом репутацию сайта будет сложно.

Начинающие раскрутчики своего сайта, как правило, совершают одни и те же ошибки. Рассмотрим 9 самых распространенных ошибок.

1. Выбор оптимизатора

Важно понимать, что вебмастер и оптимизатор, это две разные профессии. Тот, кто делает хорошие сайты, не обязательно умеет их хорошо раскручивать. А тот, кто умеет хорошо раскручивать сайты, не обязательно умеет хорошо их делать.

У вебмастера и оптимизатора разные мозги. У вебмастера мозги работают примерно как у верстальщика газет и журналов и у дизайнера. В то время как у оптимизатора мозги больше работают, как у человека, который занимается экономическими и естественнонаучными исследованиями. Ведь главная задача SEO-специалиста, это математический анализ работы поисковых систем. В то время как многие люди часто думают, что оптимизация сайта под поисковые системы, это просто такое ремесло, рутинная работа по заранее известным рецептам и инструкциям.

На самом деле, оптимизатор должен разбираться в особенностях работы поисковых систем, знать все функции и типы ссылок, понимать особенности наращивания ссылочной массы, уметь применять разные способы оптимизации к разным сайтам. Плюс к этому, SEO-специалист должен знать основы копирайтинга и маркетинга.

Сначала раскручивать свой сайт можно и самостоятельно, так как в SEO присутствуют такие основы, которые не меняются с течением времени. Это то, что практически никогда не меняется при изменении алгоритма поисковых систем.

На этом этапе раскрутки идет чисто техническая ремесленная работа. Это работа типа проверка длины содержания тегов title и description, поиск битых ссылок и битых картинок, расстановка иерархии заголовков в теги H, установка атрибутов nofollow в тех ссылках, где это необходимо, редактирование файла robots.txt, создание карты сайта и т.п.

Эта работа вполне по силам любому новичку. Но потом всё равно придётся искать опытного оптимизатора.

2. Технические ошибки

К техническим параметрам сайта, которые влияют на его продвижение, относятся такие параметры, как:

- Время загрузки страниц сайта

- Наличие и корректность файла robots.txt

- Наличие битых ссылок

- Наличие битых картинок

- Наличие на сайте дублей страниц

- Наличие страницы ошибки 404.

- Наличие и корректность карты сайта

- Настройка редиректов через файл .htaccess

- Наличие title и его правильное заполнение

- Наличие description и его правильное заполнение

- Наличие атрибутов nofollow в ссылках и метатегах

- Наличие ошибок в html-структуре вложенности тегов

- И другие

В Интернете можно найти много разных анализаторов, которые могут бесплатно проверить страницы сайта на наличие таких технических ошибок.

3. Скорость загрузки страниц сайта

Среди всех технических факторов, скорость загрузки страниц в браузере пользователя, это самый главный технический фактор, который влияет на раскрутку сайта. Всем понятно, что если у каких-то пользователей страница будет загружаться несколько минут, то посетитель сайта не станет так долго ждать. Он закроет вкладку с таким сайтом и перейдёт на следующий сайт, например, из поисковой выдачи. Переходы на такой "тормознутый" сайт по ссылкам из поиска приведут к ухудшению поведенческих факторов. А это значит, что такой сайт может сильно потерять свои позиции в поисковой выдаче.

Самая распространенная причина слишком долгой загрузки страниц сайта, это присутствие на них большого числа очень больших картинок. Иногда на сайте размещают фотографии размером по несколько мегабайт. Такие фотографии имеют разрешение пригодное для их рассматривания на принтерных распечатках, но для экрана монитора, это избыточное разрешение. Нормально, когда на страницах сайта находятся фотографии и рисунки размером 100-500 килобайт. А идеально, когда все картинки размером меньше 100 килобайт.

Еще одна очень распространенная причина долгой загрузки страниц сайта, это нехватка ресурсов на хостинге, где размещен сайт. При увеличении количества посетителей на сайт необходимо переходить на тариф с адекватным количеством ресурсов, которое сервер выделяет сайту.

Ещё важно не перегружать страницы браузерными сценариями. Сервер на хостинге при этом не нагружается. А вот браузеры пользователей отдают много ресурсов для загрузки таких страниц. Часто такое бывает, когда хотят разместить на страницах сайта крутой дизайн с анимацией.

4. Семантическое ядро

Главный принцип создания семантического ядра, это его полнота. Неопытные новички часто включают в семантическое ядро только несколько высокочастотных запросов и пишут под них тексты. Потом смотрят, какой получился результат.

Но результат, обычно, бывает очень печальным. Дело в том, что у таких высокочастотных запросов, как правило, очень высокая конкурентность. На вершине поисковой выдачи по таким запросам находятся сайты с такими текстами, которые созданы высокооплачиваемыми профессиональными копирайтерами. У таких сайтов высокооплачиваемые профессионалы оптимально выверили ссылочный профиль. Возраст таких сайтов, обычно, не менее 4-5 лет.

Но это совсем не означает, что из семантического ядра нужно выкинуть все высокочастотные поисковые запросы. Ни в коем случае! Просто при старте раскрутки своего сайта сначала надо писать тексты под низкочастотные фразы. Если войти в топ поисковой выдачи по нескольким низкочастотным фразам, то потом будет уже гораздо легче подняться в топ по среднечастотным фразами. А затем будет легко подняться в топ и по высокочастотным фразам.

5. Кластеризация

Кластеризация, это правильная группировка запросов из семантического ядра. Такую группировку обычно делают для того, чтобы правильно распределить ключевые фразы по разным страницам сайта.

Дело в том, что каждая страница сайта должна продвигаться не по одной ключевой фразе, а, как правило, минимум по 3-4 поисковым запросам. При этом страницы сайта не должны конкурировать между собой. То есть нельзя продвигать две разные страницы сайта по одним и тем же ключевым словам, даже если тексты на этих страницах рассказывают об одном и том же.

Достигается это правильным распределением ключевиков по страницам сайта. Нужно тематически объединить все ключевые фразы сначала в большие группы. Затем конкретизировать их тематики и разбить эти крупные группы на более мелкие тематические группы. И так далее, пока в группах не останется от 3-4 до 6-9 поисковых фраз. На каждую такую самую мелкую группу должна быть своя отдельная страница сайта.

Основной трафик из поисковых систем на сайты как раз и идет по низкочастотным запросам, которые присутствуют в мелких группах. Находить такие запросы удобно в сервисе WordStat Яндекса.

6. Поведенческие факторы

По поведенческим факторам поисковики определяют востребованность сайта и соответствие страницы сайта разным поисковым запросам. К поведенческим факторам сайта относятся такие параметры, как:

- Время, проведенное на сайте и на каждой странице в отдельности

- Количество просмотренных страниц

- Показатель отказов от просмотра сайта

- Возвраты на сайт в течение заданного периода

- Активность на сайте (скроллинг, движения мышью, клики и т.п.)

- Возврат с сайта обратно в поисковую выдачу

Бессмысленно искусственно накручивать показатели поведенческих факторов с помощью разных сервисов, которые предлагают такие услуги. Поисковые системы умеют очень хорошо распознавать неестественное поведение посетителей сайта и игнорируют вклад таких "неестественных" посетителей в поисковое ранжирование.

Для улучшения поведенческих факторов нового сайта надо:

- улучшать удобность сайта для посетителей

- чаще размещать интересные для пользователей материалы

- инициировать обсуждения

- больше размещать картинок и видеороликов

- больше размещать внутренних ссылок там, где они уместны

Когда сайт еще новый, то его поведенческие метрики еще не сформировались и поисковые системы ещё не набрали по нему достаточно большую статистику. Поэтому пока в поисковой выдаче такой сайт не ранжируется по поведению посетителей сайта.

Это дает шанс анализировать поведение буквально каждого посетителя сайта и оперативно исправлять обнаруженные ошибки. Анализ посетителей сайта можно делать с помощью таких сервисов Яндекс-Метрики, как, например, Вебвизор, Карта Кликов и Скролинг.

7. Линкбилдинг

Внешние ссылки на сайт всё ещё продолжают играть роль для продвижения сайта. Но новичкам пользоваться линкбилдингом надо очень осторожно. Иначе можно наломать много дров.

Например, резкая массовая закупка ссылок на свой сайт ("ссылочный взрыв") не останется незамеченным поисковыми системами и приведет к тому, что поисковики не станут учитывать всю эту ссылочную массу, которая ведет на ваш сайт. При этом под "раздачу" поисковых систем попадут и обычные естественные ссылки. Причем, наказание ("фильтр") может продолжаться до тех пор, пока Вы не уберете все покупные ссылки на свой сайт.

На сайт нужны самые разные внешние ссылки. Нужны ссылки не только с других сайтов похожей тематики, но и ссылки из социальных сетей и из форумов (крауд-ссылки). Покупать такие ссылки можно, но только по чуть-чуть и равномерно без ссылочных взрывов и ссылочных ям. Особенно надо следить за тем, чтобы количество покупных ссылок никогда не превышало количество естественных ссылок.

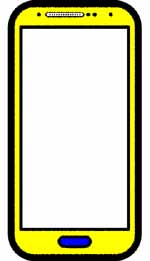

8. Адаптированность для мобильных устройств

Исторически получилось так, что сайтостроение сначала развивалось только для настольных компьютеров. Но потом появились смартфоны и планшеты. И сайты, которые приятно и легко рассматривать на экране монитора, стало затруднительно посещать через мобильные устройства.

Реальность такова, что сейчас уже около половины пользователей Интернета бродят по его просторам при помощи мобильных гаджетов. Поисковики это учитывают и требуют, чтобы все сайты были адаптированы и для их просмотра через мобильные устройства.

Если сайт не адаптирован для просмотра на мобильных устройствах, то поисковые системы сейчас понижают позиции такого сайта в поиске на мобильном устройстве. А Гугл, вообще, теперь считает мобильный поиск более главным. То есть если сайт не адаптирован для мобильных пользователей, то в поиске Гугла он может потерять трафик и из обычной десктопной поисковой выдачи.

9. Не бросайте раскрутку из-за первых неудач

Практически все оптимизаторы порой сталкиваются с такой ситуацией, когда они всё делают правильно, а сайт по нужным ключевым словам ну никак не хочет подниматься в поисковой выдаче на более высокие места. Такое бывает не только у начинающих, но и у профессионалов.

Тут важно не отчаиваться. Нужно понимать, что раскрутка нового сайта или новой страницы сайта порой не всегда сразу же приводит к высоким позициям в поисковой выдаче. Иногда ждать результата приходится месяцами.

Для молодых сайтов еще встречается и такая ситуация, когда по нужной поисковой фразе сайт то попадает на первую страницу выдачи, то через неделю на сотую страницу выдачи. А потом обратно. То есть такая "лихорадка" на выдаче. Чаще всего это связано с тем, что поисковик временно поднимает страницу сайта в поиске, чтобы посмотреть на её поведенческие факторы и набрать статистику по ним. Это шанс данной странице сайта закрепиться в ТОП-10.

Поэтому проявляйте терпение. Настойчивость и целеустремлённость обязательно приведут к раскрутке Вашего сайта.

------------------

Автор статьи: Евгений Миронов.

ИКС Яндекса, это ИКСПЯ или ИКССЯ?

Общие сведения об ИКС Яндекса

В конце августа 2018 года Яндекс представил новый показатель для сайтов, названный ИКС, что значит Индекс Качества Сайта. Этот индекс, как бы, будет вместо тИЦ (тематический Индекс Цитирования), который перестали пересчитать более года назад.

На конец августа 2018 года самые большие показатели ИКС имели сайты Вконтакте и YouTube, по 340'000. Это больше, чем ИКС у Гугла равный 120'000 для google.com и 130'000 для google.ru. ИКС своих сайтов Яндекс принципиально не показывает.

Пока ИКС для поддоменов точно такой же, как и для домена. Но не всегда. Например, у всех Народных сайтов на поддоменах домена narod.ru ИКС разный. У некоторых поддоменов Гугла ИКС не считается, например, в конце августа 2018 неизвестен ИКС у translate.google.com. Видимо, в будущем у всех доменов и их поддоменов ИКС будет разным.

ИКС, это следствие или причина?

Яндекс утверждает, что ИКС не является причиной более или менее высокой позиции сайта в поисковой выдаче. То есть при формировании поисковой выдачи, алгоритм ранжирования результатов не учитывает ИКС, не смотрит на ИКС, и, вообще, значение ИКС не входит в формулу, которая определяет, куда попадет страница сайта в поиске.

Яндекс утверждает, что это, наоборот, при подсчете ИКС учитывается, какой трафик получает сайт. То есть в формулу расчета ИКС могут входить параметры сайта из поисковой выдачи.

Поэтому накрутка ИКС может не привести к увеличению органического трафика сайта из поиска, так как алгоритм поиска ничего не знает о существовании какого-то ИКС. А вот, наоборот, если органический трафик на сайт увеличится, то это обязательно увеличит его ИКС. Ибо в формулу ИКС должны входить показатели поискового трафика сайта.

Таким образом, ИКС, это не причина того, что какой-то сайт имеет очень высокие или, наоборот, очень низкие показатели в поисковой выдаче. А, наоборот, очень маленький ИКС или очень большой ИКС являются следствием, в том числе и того, что на сайт идет маленький или большой трафик из поиска.

Итак, ИКС, это интегральная пузомерка, которая является следствием того, что с сайтом или всё плохо или, наоборот, всё хорошо, а не причиной того, что с сайтом всё плохо или, наоборот, всё хорошо.

Какова истинная цель Яндекса

Самым непонятным во всей этой истории с ИКС является то, какую цель преследует Яндекс, сделав общедоступной информацию об ИКС. Причём, информация об ИКС доступна не только о своём сайте, но и о других сайтах.

Официально, конечно, Яндекс объяснил, зачем он ввел новую пузомерку и сделал информацию о ней общедоступной. Но мы эту версию даже повторять тут не будем. Нас интересуют истинные причины такого поведения Яндекса, а не то, что Яндекс вбрасывает публике.

Вопрос этот далеко не праздный. Поведение Яндекса является более чем странным.

При чем здесь бизнес продажных ссылок

Дело в том, что ИКС это царский подарок индустрии продажи ссылок. Бизнес по купле-продаже ссылок фактически в Рунете уже умирал. Весь этот бизнес опирался на такие показатели сайта, как PR Гугла и тИЦ Яндекса. Чтобы объяснить покупателям ссылок, почему ссылка с одного сайта имеет цену в два раза больше, чем ссылка с другого сайта, биржи по продаже ссылок тыкали покупателя носом в PR и тИЦ этих сайтов. Таким образом, PR и тИЦ были существенными показателями качества продаваемых товаров на этих ссылочных биржах.

Но этот бизнес наносил урон качеству сайтов и качеству поисковой выдачи. В самом деле, зачем работать над качеством своего сайта, когда можно просто накупить на свой сайт большое количество внешних ссылок. В результате в топ выдачи оказывались плохие сайты с большим числом купленных внешних ссылок. А хорошие качественные сайты, которые не покупали ссылки, порой в поиске занимали невысокие места по сравнению с покупателями большого количества ссылок.

Поисковые системы стали бороться против этого явления. Они наказывали своими фильтрами и пессимизацией в выдаче тех, кто покупал такие ссылки и тех, кто продавал такие ссылки.

Казалось бы, решением проблемы должен стать полный отказ от учета ссылок на сайт при формировании поисковой выдачи. Но по причинам, описанным в этой статье нашего блога, полностью отказаться от учета внешних ссылок просто невозможно.

Тогда Гугл решил убить индустрию продажи ссылок тем, что он перестал показывать PR (или то, чем он заменил показатель PR). И это имело успех. Индустрия продажи ссылок в Буржуйнете практически сдохла.

Но в Рунете Яндекс продолжал показывать тИЦ сайтов, и поэтому индустрия продажных ссылок продолжала существовать. Яндекс даже перестал пересчитывать тИЦ сайтов, но продолжал показывать этот устаревший индикатор публике. И поэтому индустрия продажных ссылок продолжала существовать и формировать свои цены.

Когда Яндекс перестал пересчитывать у сайтов их тИЦ, то в Рунете появились конторы, которые стали предлагать альтернативы этого показатели в виде разных показателей траста сайта. Например, как этот сайт. Но все эти сайты никогда не были так авторитетны, как Яндекс или Гугл и поэтому эти их эксперименты по замене тИЦ нельзя назвать удачными. Кроме того, зачем изобретать новые индикаторы, если всё ещё есть понятный старый добрый тИЦ.

И вот теперь, вместо того, чтобы последовать примеру Гугла и убрать этот тИЦ с глаз долой и ничего не показывать взамен, Яндекс, убрав тИЦ, тут же начинает публичный показ новой пузомерки ИКС. И совсем не важно, что этот ИКС имеет маленькое отношение к теме позиций сайта в поисковой выдаче. Ссылочные биржи всё равно возьмут этот ИКС за инструмент ценообразования на ссылки. Ведь и тИЦ в своё время имел маленькое отношение к поисковой выдаче, он только ранжировал сайты в каталоге Яндекса, но его, тем не менее, взяли за основу ценообразования при продаже ссылок.

Ну, придумали они в Яндексе какой-то новый показатель качества сайта, ну и смотрели бы на него только сами, как Гугл. Зачем показывать его всем подряд? Им что, денег что ли не надо? Ведь по идее, все эти покупатели ссылок после смерти ссылочных бирж должны были притащить свои деньги в Яндекс-Директ.

Да, именно в Яндекс-Директ, а не веб-дизайнерам и копирайтерам, так как улучшение дизайна сайта, его юзабилити и текстов на нём еще не гарантирует усиление поведенческих факторов и, как следствие, не гарантирует увеличение трафика из поиска.

Ведь чем подкупала покупка ссылок? Да, своей формальной простотой. Заплатил деньги и гарантировано получил трафик. Не надо изучать посетителей своего сайта, их психологию, думать, что им нужно и что не нравится на сайте. При использовании Яндекс-Директа та же самая философия быстрого получения гарантированного трафика без каких-то сложных и долгих работ с сайтом без гарантии трафика. Поэтому клиенты ссылочных бирж, это готовые клиенты Яндекс-Директа, а не веб-дизайнеров и копирайтеров.

Именно поэтому поведение Яндекса выглядит очень странным.

Является ли ИКС Яндекса ИКСПЯ?

Теперь включаем логику. Допустим, Яндекс не интересуют дополнительные деньги. Допустим, Яндекс ввел ИКС и сделал его общедоступным просто из-за любви к искусству, чтобы показать всем силу своего интеллекта, и не более.

Давайте теперь думать, как Яндекс и рассуждать как Яндекс в модели честного объективного Яндекса, для которого все сайты равны.

ИКС и вовлеченность сайта в сервисы Яндекса

В этом случае получается, что такие вещи, как установка на сайте Яндекс-Метрики не должна влиять на ИКС сайта. Вообще, участие сайта в разных сервисах Яндекса не должно влиять на его ИКС никоим образом.

Ведь при честном подходе и равном отношении ко всем сайтам, учет данных Метрики на одном сайте будет несправедливым по отношению к тому сайту, который не установил у себя Метрику.

Представьте себе, что два сайта имеют одинаковый трафик из поиска Яндекса. Но на одном из этих сайтов стоит Метрика. И она показывает дополнительный очень большой трафик на сайт из поиска Гугла, из социальных сетей и по ссылкам с других сайтов. И этот трафик очень качественный, мало отказов, большое количество просмотренных страниц, большое время пребывания людей на сайте.

Спрашивается, как Яндекс получит те же самые данные по трафику, пришедшему из Гугла, из других сайтов и из соцсетей для того сайта, который не установил у себя Метрику? Если этот сайт, вообще, не зарегистрирован ни в одном сервисе Яндекса? Ни в Яндекс-Справочнике, ни в Яндекс-Дзен, вообще, нигде там, где Яндекс мог бы получить какую-то дополнительную информацию о трафике на этот сайт из других источников трафика, кроме поиска Яндекса.

Многие люди, которые уже продолжительное время находятся в теме SEO, порой уже не представляют, что есть очень много сайтов, на которых Метрика не установлена. Например, на FaceBook не стоит Метрика Яндекса, значит, Яндекс ничего не знает о трафике на какой-нибудь сайт с ФейсБука, если на том сайте не стоит Метрика. Метрика не установлена ни на одном сервисе Гугла. Значит, если на сайте нет Метрики, то Яндекс ничего не знает о трафике на сайт с сервисов Гугла.

Точно также в Рунете есть много сайтов, на которых Метрика тоже не установлена. Поэтому Яндекс ничего не подозревает о трафике между такими сайтами. А этот трафик между такими сайтами может быть не малым по сравнению с трафиком из поиска Яндекса, с учетом того, что хозяева этих сайтов не озабоченные.

Из-за того, что владельцы таких сайтов, как правило, не озабочены, часто эти сайты, с одной стороны, имеют не слишком высокие позиции в поиске из-за своих "грехов", типа отсутствия мобильной версии, отсутствия title и description и т.п. А, с другой стороны, эти сайты могут быть очень популярными из-за очень хороших оригинальных авторских текстов без всякого рерайта. Вы можете найти на таких сайтах то, что не найдёте больше нигде. Их материалы ещё не успели отрерайтить на других сайтах.

Спрашивается, если Яндекс одинаково относится ко всем сайтам при подсчете ИКС, то, как он считает ИКС у таких сайтов, которые не зарегистрированы ни в одном сервисе Яндекса?

Данные для ИКС из поиска Яндекса

Если задуматься над этим, то самый честный вариант подсчета ИКС состоит в уравнивании источников данных для всех сайтов. То есть, если какие-то данные Яндекс может получить только из Метрики и больше никак, то эти данные в расчете ИКС не должны участвовать, ибо непонятно, что в формулу ИСК надо поставлять, когда у Яндекса нет таких данных о сайте.

Таким образом, в модели честного Яндекса получаем, что формальная регистрация своего сайта в сервисах Яндекса ничего не дает в плане увеличения ИКС сайта. Яндекс должен учитывать в формуле ИКС только те данные, которые он может получить со всех сайтов, в том числе и с сайтов, которые не зарегистрированы ни в каком из сервисов Яндекса.

Это такие данные, как:

- контент сайта (тексты, картинки, аудио и видео на сайте), в том числе и метатеги вебстраниц;

- ссылки на сайт (внешние и внутренние, seo или естественные);

- ссылки с сайта на другие сайты, на сколько они уместные и логичные;

- количество страниц сайта;

- трафик на сайт из поиска Яндекса;

- какие страницы сайта получают трафик с поиска Яндекса, а какие нет;

- сколько времени проводит пользователь с поиска Яндекса на сайте, прежде чем вернуться обратно в поиск;

- есть ли мобильная версия сайта;

- сколько времени грузятся страницы сайта;

- какие в Интернете оставлены отзывы про сайт;

- есть ли сообщества в соцсетях, посвященные сайту;

- и т.п.

Все эти данные сайта Яндекс может получить о любом сайте, который принимает участие в поиске Яндекса.

Если сайт неизвестен поисковой системе Яндекса, то ИКС для него не считается. Можете сами проверить это на каком-нибудь очень качественном сайте из американской глубинки, который получает большой трафик с Гугла и Яху.

Нужна ли регистрация в сервисах Яндекса для роста ИКС

Это не значит, что совсем не нужно регистрировать свой сайт в сервисах Яндекса. Речь идет о том, что формальная регистрация в сервисах Яндекса никак не поднимает значение ИКС в модели честного Яндекса.

Другое дело, если такая регистрация будет использована вебмастером с пользой для самого сайта. Например, зарегистрировавшись в Яндекс-Вебмастер можно воспользоваться его сервисом ускорения загрузки мобильных страниц "Турбо-Страницы". Часть страниц сайта будут грузиться быстрее. Это чуть-чуть увеличит значение ИКС, так как, скорее всего, пусть даже и с очень маленьким весовым коэффициентом, но в ИКС должна учитываться средняя скорость загрузки страниц. Все поисковики считают высокую скорость загрузки страниц признаком качества сайта по той причине, что часть пользователей не ждёт окончания загрузки долгогрузящейся страницы и уходит с сайта.

Возможно, именно поэтому некоторые исследователи ИКС наблюдают некоторую корреляцию между величиной ИКС и присутствием сайта в некоторых сервисах Яндекса. Это, скорее всего, в модели честного Яндекса объясняется именно тем, что вебмастера этих сайтов воспользовались информацией этих сервисов для улучшения своего сайта.

То же самое, что и о сервисах Яндекса, можно сказать и об асессорах Яндекса и его толокнянах. В рамках модели честного Яндекса оценки асессоров и толокнян не должны влиять на ИКС сайта, так как таких оценок нет для всех сайтов. Или, по крайней мере, нет оценок асессорами и толокнянами для всех сайтов одновременно за один месяц. (ИКС обещают пересчитывать ежемесячно.)

Итак, в рамках модели честного Яндекса ИКС, на самом деле, является ИКСПЯ, то есть Индекс Качества Сайта в Поисковике Яндекс (или в Поиске Яндекса).

Является ли ИКС Яндекса ИКССЯ?

Но если ИКС является ИКСПЯ, то это никак не объясняет нам, почему всё таки Яндекс сделал информацию об этом индексе открытой. У Гугла, наверняка, есть подобный индекс, но он не распространяет информацию о нем для всех, чтобы не возрождать индустрию продажи ссылок.

Есть другая гипотеза. Это гипотеза о том, что, на самом деле, Яндекс более хитрый, чем честный.

В рамках модели хитрого Яндекса ИКС является не ИКСПЯ, а ИКССЯ, то есть Индекс Качества Сайта в Сервисах Яндекса. (Уловили разницу между одним сервисом Яндекса, который поиск, и всеми другими сервисами Яндекса?)

Подозрения относительно ИКС

Да есть такое подозрение и оно очень сильное. На некоторую корреляцию между величиной ИКС и вовлеченность сайта в сервисы Яндекса (Директ, Справочник и др.) первыми обратили внимание некоторые форумчане на SearchEngines уже в первый день после появления ИКС в открытом виде.

В блоге сервиса 1PS об этом говорится чуть ли не как о доказанном факте: "В учет идут все сервисы Яндекса - от Дзена до Яндекс.Карт. И теперь вы просто обязаны во все эти сервисы попасть...". В статье ссылаются на то, что Яндекс в своём сообщении об ИКС прямо указывает, что информацию о сайтах он берет из своих сервисов (во множественном числе, а не в единственном) и что он хочет этим индексом оценивать даже полезность бизнеса, стоящего за сайтом, для пользователей Интернета. Такая полезность для пользователей Интернета во многом оценивается именно через сервисы Яндекса.

Или, например, на сайте МегаИндекс автор статьи про ИКС и три комментатора говорят о том, что на величину ИКС оказывает влияние type-in трафик. То есть такой трафик, когда посетитель сайта не переходит на сайт по ссылке, а сам вбивает доменное имя сайта в строку браузера. Но сведения про такой трафик Яндекс может получить только или если на сайте установлена Яндекс-Метрика, или если посетитель сайта сидит в Яндекс-Браузере.

Есть много других примеров, которые усиливают подозрение, что Яндекс при вычислении ИКС использует такие данные своих сервисов, которые нельзя получить без этих сервисов. Если это так, то спрашивается, что подставляется в формулу ИКС при вычислении ИКС для сайтов, которые не зарегистрированы в сервисах Яндекса?

Тут два варианта.

Эвристика или наказание

Или в формулу вычисления ИКС подставляется "средняя температура по больнице" или сайты, не зарегистрированные в сервисах Яндекса (или зарегистрированные в маленьком числе этих сервисов), получают пенальти от Яндекса в виде понижения их ИКС (за свою скрытность).

Первый вариант представляется очень маловероятным. Слишком велика дисперсия "температуры по больнице". Всякий, кто раскручивал не один, а несколько сайтов знают, что органический трафик от Гугла и Яндекса могут быть одинаковыми, а могут различаться более чем в 5 раз в ту или другую сторону. Из соцсетей трафика на сайт может не быть совсем, а может этот трафик составлять более 80% от всего трафика на сайт.

Поэтому подстановка "средней температуры по больнице" в формулу ИКС может привести к грандиозным ошибкам в величине ИКС для сайтов, которые не зарегистрированы в сервисах Яндекса или зарегистрированы в маленьком количестве этих сервисов.

Хотя тут всё снова упирается в цели Яндекса. Возможно, Яндексу наплевать на такие сильные неточности в вычислении ИКС. Может для Яндекса важен только сам факт того, что есть такая пузомерка, значение которой может обозревать сеошная публика. А может быть сайтов, которые не установили у себя Метрику и не зарегистрированы в паре сервисов Яндекса, уже так мало, что Яндексу наплевать на этот маленький процент таких сайтов. Возможно, динамика такова, что Яндекс прогнозирует, что через 5 лет таких сайтов уже не будет. Тут разные могут быть причины того, что Яндекс может сознательно неправильно вычислять ИКС некоторых сайтов.

Но всё таки мне кажется, что вариант "средней температуры по больнице" в модели хитрого Яндекса менее вероятен, чем вариант низкого ИКС для "еретиков", пренебрегающих "храмами" Яндекса.

Цель Яндекса

Яндекс своим публичным ИКС, как бы, даёт понять веб-мастерам, в каких "храмах" надо присутствовать (и кому "молиться"). Как минимум, Яндекс желал бы, чтобы все сайты Рунета были бы зарегистрированы в Яндекс-Вебмастер и установили бы у себя Метрику. А, как максимум, чтобы все сайты ещё были бы зарегистрированы минимум десятке других сервисов Яндекса. В первую очередь, в таких сервисах, как Директ, Справочник, Карты, Деньги, Касса, Аудитории, Реклама, Маркет, Доставка и в подобных сервисах, предназначенных для ведения бизнеса.

В результате Яндекс идет по пути создания мифа о том, что присутствие сайта в сервисах Яндекса каким-то образом влияет на отношение Яндекса к сайту. (Ну, наверное, действительно влияет на отношение, но не на позиции в поисковой выдаче.) Причем, этот миф создается не столько Яндексом, сколько SEO-сообществом, их исследованиями пузомерки ИКС. А дело Яндекса, это всего лишь сделать пузомерку зависимую от участия сайта в сервисах Яндекса и вбросить эту пузомерку в СЕО-сообщество.

Такой способ привлечения вебмастеров в свои сервисы более эффективный, чем просто прямо пригласить их туда. Например, некоторые вебмастера опасаются устанавливать на своих сайтах Метрику по той причине, что считают это методом шпионажа Яндекса за аудиторией сайта. Но они могут изменить своё решение, если одна только установка Метрики повышает трастовость сайта в глазах Яндекса. Они ещё более охотнее сделают это, если поверят, что ИКС как-то влияет на позицию сайта в поиске Яндекса.

Зачем Яндексу это нужно?

Война с Гуглом

Это диктует логика его войны с Гуглом. Яндекс уже несколько лет подряд проигрывает войну Гуглу. Доля русскоязычных поисковых запросов в Гугле растёт, а в Яндексе падает. И Яндекс ничего не может с этим поделать. Стандартные методы конкурентной борьбы не помогают. Гугл владеет этими методами лучше Яндекса.

Проигрыш конкурентной борьбы Гуглу грозит Яндексу потерей доходов от своего самого любимого источника доходов, от Директа. Просто ситуация может обернуться даже тем, что если не показывать никакой пузомерки SEO-сообществу и убить рынок продажных ссылок, то все покупатели продажных ссылок окажутся не в Директе, а в ЭдВордсе. В общем, потеря доходов от индустрии продажи ссылок для Яндекса не такая большая, как общая потеря доходов от поражения в конкурентной борьбе с Гуглом.

Сильная сторона Гугла, это его многочисленные сервисы, благодаря которым Гугл очень хорошо знает аудиторию Интернете, в том числе и аудиторию Рунета. Яндексу просто необходимо вовлечь свою аудиторию в свои сервисы как можно больше, чтобы как следует изучить её и её потребности.

Особенно важным для Яндекса является присутствие в его сервисах сайтов, за которыми стоит какой-то реальный бизнес. Ибо это очень платежеспособная аудитория. Её и её потребности нужно изучить в первую очередь. Именно поэтому в заявлении Яндекса идут намёки на то, что Яндекс хотел бы с помощью ИКС оценивать не только сами сайты, но и бизнес, стоящий за ними.

Поэтому есть и такая версия про хитрый Яндекс, что ИКС, это на самом деле ИКССЯ. И что вбрасыванием нужной информации в SEO-сообщество, Яндекс пытается манипулировать вовлеченностью сайтов в свои сервисы.

Какая из двух версий (честный Яндекс и ИКСПЯ или хитрый Яндекс и ИКССЯ) более правильная, покажет время.

Вместо заключения

Выводов никаких по этой статье не делаю и вместо заключения просто расскажу о своих наблюдениях значений ИКС.

На своих сайтах заметил только одну корреляцию. ИКС коррелирует с отношением количества трафика с Яндекса к количеству всех страниц в поиске Яндекса.

Примерно это выглядит так. Есть два сайта. На первом посещаемость около 100 в день с поиска Яндекса и количество страниц в индексе Яндекса около 2500. Отношение трафика к числу проиндексированных страниц примерно 0.04. На втором посещаемость около 30 с поиска Яндекса и количество станиц в индексе 42. Отношение трафика к числу проиндексированных страниц тут уже примерно 0.71. При этом ИКС второго сайта на порядок больше, чем ИКС первого сайта.

Кроме того, трафик с поиска Яндекса на первом сайте идет практически только примерно на 120 страниц, то есть около 4% от всех страниц в индексе Яндекса. Все остальные страницы этого сайта для поисковой системы Яндекса являются, как бы, бесполезным ненужным балластом. В то время, как на втором сайте трафик с Яндекса получает примерно 20 страниц, то есть около 50% всех проиндексированных страниц. Возможно, это тоже играет роль при подсчете ИКС.

В любом случае нужно будет посмотреть, можно ли как-то на первом сайте уменьшить число страниц, которые совсем не получают трафик, не только от Яндекса, но и от Гугла и из соцсетей и с других сайтов. Нужно будет решить, как правильно сократить число страниц. Тут три варианта:

- Просто уничтожить страницу.

- Объединить несколько страниц в одну страницу.

- Через файл robots запретить Яндексу индексировать эти страницы.

Если будет какой-то результат, то обязательно напишу об этом.

------------------

Автор статьи: Евгений Миронов.

14 марта 2017, 19:53

Продвижение новых сайтов

Сейчас тема раскрутки молодых сайтов очень популярна. На это есть свои причины. В последнее время, чтобы раскрутить недавно созданный сайт (или даже старый сайт, который долгое время был заброшенным) нужно много времени. Сейчас уже не получится купить очень много ссылок и за счет ссылочной массы выйти на первую страницу поисковой выдачи, как это было раньше, например лет 10 назад. Теперь поисковые системы попросту не допускают в топ своей поисковой выдачи такие сайты, которым они не доверяют, которых они не знают или мало знают.

Что же теперь делать новым только что появившимся сайтам? Попробуем разобраться.

Внутренняя оптимизация сайта

Начинать работу по раскрутке молодого сайта в поисковых системах нужно с внутренней оптимизации сайта. Для этого нужно правильно распределить семантическое ядро по страницам сайта. Значит, начинать работу надо с составления первичного семантического ядра. Особенность первичного семантического ядра для новых сайтов состоит в том, что оно должно содержать только низкочастотные и среднечастоные поисковые запросы. Никаких высокочастотников! Основной упор нужно сделать на низкочастотники. Более подробно о составлении семантического ядра можно прочитать тут.

После составления первичного семантичиского ядра с подобранными низкочастотниками и среднечастотниками, дальнейший план действия следующий:

- Проверка технических недостатков сайта и их исправление. Это всякие дубли страниц, битые ссылки, вирусы и т. п.).

- Проверка уровня уникальности текстов. Тексты с низким уровнем уникальности придется переписать заново. Да, да, даже если это Ваши уникальные оригинальные авторские статьи и тексты, которых уже успели растащить по другим сайтам.

- Составление и прописывание корректных тегов title и description на базе созданного распределения семантического ядра по страницам сайта.

- Правильная установка заголовков h1-h6 на страницах сайта с использованием нужных ключевых фраз из распределения семантического ядра по страницам.

- Правильное составление текстов в атрибутах alt и title для картинок.

- Генерация карты сайта и файла robots.txt.

- Правильная перелинковка между страницами сайта.

- Добавление сайта в сервисы вебмастера Яндекса и Гугла.

- И другие работы.

Это всего лишь небольшой список работ по оптимизации своего нового сайта, которые нужно обязательно провести в самом начале. Это обязательный достаточный минимум.

Важно понимать один очень важный момент. Оптимизация сайта, это не одноразовый, а постоянный процесс. Остановка этого процесса грозит снижением позиций сайта в поисковой выдаче. Когда на сайт добавляются новые страницы, то нужно обязательно оптимизировать эти новые страницы. Когда на сайте удаляются ненужные старые страницы, то очень часто нужно заново оптимизировать некоторые старые страницы. И в любом случае надо пересматривать или дорабатывать семантическое ядро сайта.

Если это всё кажется слишком сложным или требует много времени, то существуют сервисы, которые предлагают свои профессиональные услуги по продвижению молодых сайтов, как, например, Сервис 1PS. Их специалисты качественно и в короткий срок проведут внутреннюю оптимизацию любого молодого сайта.

Качественный полезный контент

Если на молодом сайте имеется оригинальный полезный контент, то это уже огромный успех для сайта. Чем интереснее и полезнее новый сайт для посетителей сайта, тем лучше к такому сайту будут относиться поисковые системы. Дело в том, что поисковики доверяют сайтам с оригинальным контентом. Как минимум, такие сайты в поисковой выдаче показывают на более высоких позициях, чем сайты, которые копируют чужой контент. Мало того, из-за ограниченности ресурсов поисковых систем, именно сайты с копированным контентом в первую очередь попадают в бан поисковых систем. Ибо поисковикам неинтересно забивать свои сервера тысячами копий одного и того же текста.

Яндекс и Гугл очень любят качественный контент. А качественным контентом они считают такой контент (тексты, картинки, аудио и видео), который решает какие-то задачи и проблемы посетителей Вашего сайта. Уникальные и полезные тексты для наполнения своего сайта можно заказать у seo-копирайтеров. И помните, что чем чаще обновляется контент сайта, тем лучше. Под обновление контента понимается и добавление нового контента и небольшие изменения старого контента, чтобы сделать его актуальным там, где контент уже устарел.

Для того, чтобы сообщить поисковым системам о появлении на сайте новых уникальных текстов, надо до появления нового текста сообщить об этом в сервисе Яндекс-Вебмастер в разделе "Информация о сайте" в подразделе "Оригинальные тексты". А после появления новой страницы на сайте нужно сразу же в сервисе Вебмастер Гугла в разделе "Сканирование" в подразделе "Посмотреть как GoogleBot" сначала отправить новую страницу на сканирование, а затем отправить её на индексирование.

Правильное наращивание ссылок

Ещё в 2014 году Яндекс объявил об отмене ссылочного ранжирования для коммерческих поисковых запросов. Представители поисковой системы Yandex заявили, что фактор внешних ссылок на сайт теперь не работает при формировании поисковой выдачи по коммерческим запросам. Было заявлено, что за покупку внешних ссылок на сайт будут налагаться санкции в виде пессимизации положения сайта в поисковой выдаче, вплоть до полного бана сайта. С тех пор прошло уже три года. И результаты у разных сайтов совершенно разные. Некоторые сайты по прежнему продолжают покупать внешние ссылки с других сайтов и при этом они продолжают оставаться на первых позициях в поисковой выдаче Яндекса. Видимо другие положительные факторы этих сайтов как велики, что один отрицательный фактор покупки продажных ссылок не слишком сказывается на них. Яндекс продолжает доверять этим сайтам. Ну, а некоторые сайты очень сильно пострадали из-за наличия на других сайтах огромного количества продажных ссылок, которые ведут на сайт.

Замечу, что вместо покупок внешних ссылок некоторые вебмастера сейчас занялись накруткой поведенческих факторов на своих сайтах. За такие вещи тоже можно попасть под пессимизирующие фильтры Яндекса или даже, вообще, в бан. Яндекс гораздо более жестко карает сайты за накрутку поведенческих факторов по сравнению с накруткой внешней ссылочной массы. Это связано с тем, что сейчас в Яндексе внешняя ссылочная масса на сайт играет гораздо меньшую роль в продвижении сайта, чем роль поведенческих факторов. (У поисковика Google, наоборот, внешние ссылки играют большую роль, чем поведение пользователей на сайте.)

С одной стороны, я не предлагаю новым сайтам заниматься закупкой продажных внешних ссылок. Но, но с другой стороны, я не говорю, что внешние ссылки совсем не работают. Они по-прежнему работают. Но молодым сайтам нужно наращивать внешнюю ссылочную массу естественным образом. Или хотя бы нужно имитировать естественность наращивания внешней ссылочной массы, то есть наращивать количество ссылок аккуратно и постепенно. Ни в коем случае нельзя допускать "ссылочного взрыва".

Рекомендую для молодого сайта провести следующие мероприятия по естественному наращиванию числа внешних ссылок:

- Добавьте свой сайт в аддурилки поисковых систем.

- Зарегистрируйтесь в белых каталогах сайтов.

- Участвуйте в крупных рейтингах сайтов, например, таких, как рейтинг сайтов на Рамблере.

- Напишите какую-нибудь оригинальную полезную статью и вместо того, чтобы разместить её на своем сайте, разместите её в каталогах статей. В тексте этой статьи должна быть прямая ссылка на Ваш сайт.

Эти рекомендованные мероприятия нужно повторять примерно раз в год или в полгода.

Ещё раз предупреждаю, что наращивание внешней ссылочной массы должно идти постепенно и плавно, без резких скачков. Поисковые системы умеют хорошо распознавать случаи, когда у нового сайта число внешних ссылок начинает расти неестественно быстро. При "ссылочном взрыве" молодой сайт рискует попасть под фильтры поисковых систем. Эти фильтры выражаются в том, что поисковые системы перестают учитывать на сайт не только продажные ссылки, но и все естественные ссылки с других сайтов.

Итоги

Итак, если Вы вебмастер молодого сайта, то настройте себя на постоянную работу с сайтом, постоянно оптимизируйте его. Главный акцент надо сделать на уникальном качественном контенте и на его постоянном наращивании.

Не используйте в продвижении своего нового сайта черные и серые методы продвижения, например, накрутку поведенческих факторов и закупку внешних продажных ссылок. Да, такие методы используют для своего продвижения многие сайты. Но это те сайты, которым поисковые системы уже давно доверяют. У этих сайтов огромное число других плюсов. Поэтому небольшое применение черных и серых методов раскрутки, часто, этим сайтам не вредит. А вот у Вас новый сайт, которым поисковики ещё не доверяют. И использование черных и серых методов продвижения для молодого сайта приведёт к испорченной карме нового сайта. Поисковики выдадут такому молодому сайту "волчий билет" и будут ещё долго "гнобить" сайт, отправляя его на вторую сотню в поисковой выдаче по ключевым словам, значимым для сайта.

На первом этапе рекомендую не рисковать и не заниматься самодеятельностью. Пусть лучше сначала всё сделают специалисты. Это более надёжно. Вы посмотрите на их работу, они Вас проконсультируют по многим вопросам. Тут главное выбрать правильную компанию по продвижению молодого сайта. Специалисты Сервиса 1PS уже 19 лет занимаются продвижением сайтов в поисковых системах, в том числе хорошо знают специфику продвижения новых сайтов. Они предоставляют все перечисленные выше услуги, что достаточно удобно. Рекомендую их! Почитать отзывы о работе Сервиса 1PS.

------------------

Автор статьи: Евгений Миронов.

05 января 2016, 13:17

Что такое релевантность

Это слова "релевантность" должен знать каждый, кто занимается раскруткой своего сайта. Релевантность, это, проще говоря, соответствие. Релевантный, это значит, подходящий, соответствующий. В случае SEO имеется в виду соответствие найденных в поисковой системе страниц и поискового запроса.

Яндекс определяет этот термин следующим образом. Считается, что при поиске в Интернете важны две составляющие:

- Полнота. То есть ничего не потеряно и в поисковой выдаче присутствуют все страницы, соответствующие поисковому запросу.

- Точность. Это значит, что в поисковой выдаче нет лишних документов, которые не соответствуют запрашиваемой фразе.

Грубо говоря, Вы вводите в поисковой машине фразу, например, "раскрутка сайта" и в списке сайтов, выданных поисковой системой видите страницы посвященные именно по теме раскрутки сайтов. Это считается высокой релевантностью ответа запросу. Если же Вы видите список сайтов, посвященных настольным играм, в ответ на "раскрутка сайтов", то релевантность самая низкая до нулевой.

Теперь спросим себя, а как поисковые системы определяют, какие страницы должны быть в поисковой выдаче на первом месте, а какие на пятом и на сотом месте? Поисковики, на самом деле, пытаются на первом месте выдавать самые релевантные запросу страницы. Потом идут менее релевантные, затем еще менее релевантные. И т.д.

При этом, между поисковыми машинами идет очень жесткая конкуренция за пользователей. Это обусловлено тем, что поисковые системы зарабатывают деньги на кликах по рекламе, которая идет в начале поисковой выдаче, в конце выдачи и сбоку. Поэтому каждый поисковик старается завлечь к себе в поиск как можно больше людей. Из-за этого все они стараются оптимизировать поисковые алгоритмы таким образом, чтобы выдавать наиболее релевантные запросам ответы.

Итак, если Вы хотите получать трафик на свой сайт из поисковиков, Вы должны:

- Определить какие именно слова и фразы в поисковой строке будет вбивать потенциальный посетитель вашего сайта, если он будет искать информацию или товар в Интернете.

- Создать на своем сайте такие тексты, чтобы поисковая машина решила, что содержание этих текстов является наиболее релевантным ответом на фразу, впечатанную пользователем в поисковой строке.

Для этого для начала надо поставить себя на место посетителя вашего сайта, и подумать, какую информацию ищет пользователь в ответ на тот или иной поисковый запрос.

------------------

Автор статьи: Евгений Миронов.

01 сентября 2015, 15:57

Основы продвижения сайта в поисковых системах

Что такое Search Engine Optimization (SEO)?

Поисковая оптимизация сайта (англ. Search Engine Optimization, сокр. SEO), это набор средств и мероприятий, направленных на внутреннюю и внешнюю оптимизацию сайта, с целью поднять позиции сайта в результатах выдачи поисковых систем по определенному набору поисковых запросов пользователей.

Целью такого поднятия позиций сайта в поисковой выдаче является получение сайтом интернет-трафика, то есть увеличение посещаемости сайта. Поэтому для такой SEO-оптимизации подходит не любой набор поисковых запросов, а такой набор поисковых слов и фраз, который часто используют пользователи Интернета в поисковых системах.

Проще говоря, ситуация примерно такая. Допустим, Вы хотите узнать, что такое SEO. Вы заходите в какую-нибудь поисковую систему, например, в Яндекс или Гугл. И там набираете фразу: "что такое seo". Через какие-то доли секунд поисковик выдает Вам несколько сотен тысяч (а может и миллионов) результатов. Но Вы же не будете читать все эти несколько сотен тысяч результатов. Вы прочитаете результат по самой первой ссылке. Если этого для Вас будет недостаточно, то Вы еще дополнительно почитаете результаты по второй, а может быть и по третьей ссылке.

Для большинства ситуаций информации по первой ссылке хватает 30% всех пользователей Интернета. Информации по первым 10 ссылкам на первой странице поисковой выдаче вполне хватает для 90% всех пользователей Интернета. А информации по первым 20 ссылкам хватает для более 99% всех пользователей Интернета.

Кто же на первом месте?

А теперь задайте себе такой вопрос: А кто решает, что в поисковой выдаче по данному поисковому запросу на первом месте должен быть тот самый сайт, который Вы там обнаружили?

Можно, конечно, на этот вопрос ответить и так, что это решает Гугл и Яндекс, какой у них сайт по данному запросу будет на первом месте, и, вообще, какие сайты будут по данному запросу в первой десятке, а какие не попадут даже в первую сотню. Формально это, конечно, правильный ответ. Ведь результаты поиска предоставляются всем бесплатно, а значит, первые места в поисковой выдаче невозможно купить. Они не даются тому, кто, например, больше заплатит поисковой системе. Значит, Яндекс и Гугл должны сами решать, какой сайт будет на первом месте по данному запросу, а какой будет на тысячном месте.

Но это формальный ответ. А фактически у поисковых систем есть специальный программный алгоритм, который в соответствии с тем или иным поисковым запросом ранжирует сайты в поисковой выдаче. То есть этот алгоритм сортирует все сайты Интернета в том порядке, в котором они будут присутствовать в поисковой выдаче по данному запросу. При другом поисковом запросе сайты будут ранжированы в другом порядке.

Если быть более точными, то на самом деле ранжируются при формировании поисковой выдачи не сами сайты, а определенные страницы сайтов. То есть алгоритм поисковой системы сначала на каждом сайте ищет самую лучшую страницу для данного поискового запроса, а уже затем сортирует эти страницы между собой. Но бывают иногда и исключения, когда по одному и тому же запросу в поисковой выдаче может оказаться две и более страниц одного и того же сайта.

Кроме того, у каждой поисковой системы свой алгоритм такого ранжирования страниц сайта и свой алгоритм отбора самых подходящих страниц с сайта. Достаточно вбить один и тот же поисковый запрос и в Гугле и в Яндексе, чтобы убедиться, что, во-первых, у них разный порядок сайтов в списке поисковой выдаче. И, во-вторых, они по одному и тому же запросу могут с одного и того же сайта брать разные страницы.

Алгоритм отбора нужных страниц с сайта и их последующего ранжирования использует огромное число параметром, несколько сотен, если не тысяч. Это такие параметры, как тематика сайта, частота вхождения слов поисковой фразы в текст на странице сайта, количество внешних тематических ссылок на страницу сайта, скорость загрузки сайта, сколько времени проводят пользователи на сайте, сколько страниц сайта они просматривают, удобно ли просматривать сайт на мобильном устройстве и т.д.

А SEO, это как раз набор методов и мероприятий, которые нужно проводить на своем сайте, чтобы страницы Вашего сайта ранжировались в поисковой выдаче как можно выше по нужному Вам набору поисковых слов и фраз. Идеально, когда по нужному поисковому запросу Ваш сайт находится на первом месте в поисковой выдаче. Супер идеально, если страницы Вашего сайт находятся на первых местах по всему набору интересующих Вас поисковых запросов.

Таким образом, при прочих равных условиях, Ваш сайт будет в списке поисковой выдаче по нужному Вам запросу только лишь потому, что Вы лучше Ваших конкурентов провели мероприятия по поисковой оптимизации своего сайта.

Сложность поисковой оптимизации заключается в том, что Вы не знаете алгоритма, с помощью которого формируется поисковая выдача по поисковому запросу. Алгоритм является коммерческой тайной поисковых систем. Дело в том, что если вебмастера будут знать этот алгоритм, то, используя такое знание, они замусорят поисковую выдачу поисковым спамом.

Мало того, это алгоритм не знают даже сами работники Яндекса и Гугла, которые занимаются разработкой такого алгоритма. Такие алгоритмы основаны на методах обучаемого искусственного интеллекта. Работники поисковых систем знают только как построить такой алгоритм и сделать его обучение. Но они не знают, какие в процессе обучения получились параметры алгоритма.

Тем не менее, известны основные базовые принципы ранжирования страниц сайта в поисковой выдаче. Поэтому любой вебмастер может заниматься поисковой оптимизацией своего сайта.

Для провидения SEO-продвижения сайта нужно не только иметь технические знания, но и некоторый творческий талант к этому занятию. Дело в том, что некоторые параметры своего сайта настраиваются только методом проб и ошибок. Поэтому надо хорошо понимать, что SEO-раскрутка сайта, это не только набор технических принципов по созданию сайтов, ориентированное на поисковые системы.

Почему Вашему сайту необходимо SEO?

Сейчас поисковые системы являются основными поставщиками трафика на сайты. Социальные сети и другие генераторы трафика на сайт в совокупности, конечно, могут и давать больший трафик на Ваш сайт. Но поисковики в Интернете выполняют роль основных навигаторов для большинства пользователей. Первое знакомство пользователей Интернета с Вашим сайтом, обычно, начинается с того, что на Ваш сайт этих пользователей привела какая-нибудь поисковая система. Поэтому в поисковой оптимизации нуждается любой сайт.

В оптимизации не нуждается только такие сайты, которые делаются или лично для себя или для очень ограниченного круга Ваших знакомых, которым Вы можете сами сообщить о существовании своего сайта.

Если проводить такую аналогию, что каждый сайт, это как бы такой город, или населенный пункт, или библиотека или магазин (особенно, когда, это интернет-магазин) или просто офис фирмы (например, когда это корпоративный сайт), то тогда поисковые системы, это дороги, которые ведут к сайтам. Если поисковая система не сможет найти Ваш сайт или не сможет добавить Ваш сайт в свою базу данных, то к Вам на сайт из Интернета никто не приедет. Ведь дороги-то нет.

В этом случае Вы можете только сами взять человека за ручку и привести его на свой сайт. На за ручку на свой сайт Вы приведете очень мало людей. Если к Вашему сайту ведет даже плохая дорога, то к нему приедет в тысячу раз больше людей. А если к Вашему сайту ведет высокоскоростная многополосная трасса, то к Вашему сайту приедет в миллионы раз больше посетителей.

Трудно ли сделать SEO-раскрутку сайта?

Оптимизация сайта является очень сложной процедурой. Но большинство людей могут легко понять основы этого мастерства. Порой даже небольшой объем знаний в области SEO может существенно продвинуть сайт в поисковой выдаче по нужным Вам запросам.

В Интернете можно найти много самых разных обучающих курсов по поисковой оптимизации сайтов. Некоторые из них бесплатные, но с небольшим объемом даваемых знаний. А если у Вас нет свободного времени, то можно нанять фирмы, которые специализируются на проведении работ на заказ по поисковой оптимизации сайтов.

Но в любом случае, передавая данную работу специалистам и оплачивая её, Вам лучше иметь очень четкое понимание основных концепций SEO. Это необходимо, чтобы, как минимум, Вас не обманули красивыми графиками и цифрами при отчете о проделанной работе.

------------------

Автор статьи: Евгений Миронов.

Общие сведения об ИКС Яндекса

В конце августа 2018 года Яндекс представил новый показатель для сайтов, названный ИКС, что значит Индекс Качества Сайта. Этот индекс, как бы, будет вместо тИЦ (тематический Индекс Цитирования), который перестали пересчитать более года назад.

На конец августа 2018 года самые большие показатели ИКС имели сайты Вконтакте и YouTube, по 340'000. Это больше, чем ИКС у Гугла равный 120'000 для google.com и 130'000 для google.ru. ИКС своих сайтов Яндекс принципиально не показывает.

Пока ИКС для поддоменов точно такой же, как и для домена. Но не всегда. Например, у всех Народных сайтов на поддоменах домена narod.ru ИКС разный. У некоторых поддоменов Гугла ИКС не считается, например, в конце августа 2018 неизвестен ИКС у translate.google.com. Видимо, в будущем у всех доменов и их поддоменов ИКС будет разным.

ИКС, это следствие или причина?

Яндекс утверждает, что ИКС не является причиной более или менее высокой позиции сайта в поисковой выдаче. То есть при формировании поисковой выдачи, алгоритм ранжирования результатов не учитывает ИКС, не смотрит на ИКС, и, вообще, значение ИКС не входит в формулу, которая определяет, куда попадет страница сайта в поиске.

Яндекс утверждает, что это, наоборот, при подсчете ИКС учитывается, какой трафик получает сайт. То есть в формулу расчета ИКС могут входить параметры сайта из поисковой выдачи.

Поэтому накрутка ИКС может не привести к увеличению органического трафика сайта из поиска, так как алгоритм поиска ничего не знает о существовании какого-то ИКС. А вот, наоборот, если органический трафик на сайт увеличится, то это обязательно увеличит его ИКС. Ибо в формулу ИКС должны входить показатели поискового трафика сайта.

Таким образом, ИКС, это не причина того, что какой-то сайт имеет очень высокие или, наоборот, очень низкие показатели в поисковой выдаче. А, наоборот, очень маленький ИКС или очень большой ИКС являются следствием, в том числе и того, что на сайт идет маленький или большой трафик из поиска.

Итак, ИКС, это интегральная пузомерка, которая является следствием того, что с сайтом или всё плохо или, наоборот, всё хорошо, а не причиной того, что с сайтом всё плохо или, наоборот, всё хорошо.

Какова истинная цель Яндекса

Самым непонятным во всей этой истории с ИКС является то, какую цель преследует Яндекс, сделав общедоступной информацию об ИКС. Причём, информация об ИКС доступна не только о своём сайте, но и о других сайтах.

Официально, конечно, Яндекс объяснил, зачем он ввел новую пузомерку и сделал информацию о ней общедоступной. Но мы эту версию даже повторять тут не будем. Нас интересуют истинные причины такого поведения Яндекса, а не то, что Яндекс вбрасывает публике.

Вопрос этот далеко не праздный. Поведение Яндекса является более чем странным.

При чем здесь бизнес продажных ссылок

Дело в том, что ИКС это царский подарок индустрии продажи ссылок. Бизнес по купле-продаже ссылок фактически в Рунете уже умирал. Весь этот бизнес опирался на такие показатели сайта, как PR Гугла и тИЦ Яндекса. Чтобы объяснить покупателям ссылок, почему ссылка с одного сайта имеет цену в два раза больше, чем ссылка с другого сайта, биржи по продаже ссылок тыкали покупателя носом в PR и тИЦ этих сайтов. Таким образом, PR и тИЦ были существенными показателями качества продаваемых товаров на этих ссылочных биржах.

Но этот бизнес наносил урон качеству сайтов и качеству поисковой выдачи. В самом деле, зачем работать над качеством своего сайта, когда можно просто накупить на свой сайт большое количество внешних ссылок. В результате в топ выдачи оказывались плохие сайты с большим числом купленных внешних ссылок. А хорошие качественные сайты, которые не покупали ссылки, порой в поиске занимали невысокие места по сравнению с покупателями большого количества ссылок.

Поисковые системы стали бороться против этого явления. Они наказывали своими фильтрами и пессимизацией в выдаче тех, кто покупал такие ссылки и тех, кто продавал такие ссылки.

Казалось бы, решением проблемы должен стать полный отказ от учета ссылок на сайт при формировании поисковой выдачи. Но по причинам, описанным в этой статье нашего блога, полностью отказаться от учета внешних ссылок просто невозможно.

Тогда Гугл решил убить индустрию продажи ссылок тем, что он перестал показывать PR (или то, чем он заменил показатель PR). И это имело успех. Индустрия продажи ссылок в Буржуйнете практически сдохла.

Но в Рунете Яндекс продолжал показывать тИЦ сайтов, и поэтому индустрия продажных ссылок продолжала существовать. Яндекс даже перестал пересчитывать тИЦ сайтов, но продолжал показывать этот устаревший индикатор публике. И поэтому индустрия продажных ссылок продолжала существовать и формировать свои цены.

Когда Яндекс перестал пересчитывать у сайтов их тИЦ, то в Рунете появились конторы, которые стали предлагать альтернативы этого показатели в виде разных показателей траста сайта. Например, как этот сайт. Но все эти сайты никогда не были так авторитетны, как Яндекс или Гугл и поэтому эти их эксперименты по замене тИЦ нельзя назвать удачными. Кроме того, зачем изобретать новые индикаторы, если всё ещё есть понятный старый добрый тИЦ.

И вот теперь, вместо того, чтобы последовать примеру Гугла и убрать этот тИЦ с глаз долой и ничего не показывать взамен, Яндекс, убрав тИЦ, тут же начинает публичный показ новой пузомерки ИКС. И совсем не важно, что этот ИКС имеет маленькое отношение к теме позиций сайта в поисковой выдаче. Ссылочные биржи всё равно возьмут этот ИКС за инструмент ценообразования на ссылки. Ведь и тИЦ в своё время имел маленькое отношение к поисковой выдаче, он только ранжировал сайты в каталоге Яндекса, но его, тем не менее, взяли за основу ценообразования при продаже ссылок.

Ну, придумали они в Яндексе какой-то новый показатель качества сайта, ну и смотрели бы на него только сами, как Гугл. Зачем показывать его всем подряд? Им что, денег что ли не надо? Ведь по идее, все эти покупатели ссылок после смерти ссылочных бирж должны были притащить свои деньги в Яндекс-Директ.

Да, именно в Яндекс-Директ, а не веб-дизайнерам и копирайтерам, так как улучшение дизайна сайта, его юзабилити и текстов на нём еще не гарантирует усиление поведенческих факторов и, как следствие, не гарантирует увеличение трафика из поиска.

Ведь чем подкупала покупка ссылок? Да, своей формальной простотой. Заплатил деньги и гарантировано получил трафик. Не надо изучать посетителей своего сайта, их психологию, думать, что им нужно и что не нравится на сайте. При использовании Яндекс-Директа та же самая философия быстрого получения гарантированного трафика без каких-то сложных и долгих работ с сайтом без гарантии трафика. Поэтому клиенты ссылочных бирж, это готовые клиенты Яндекс-Директа, а не веб-дизайнеров и копирайтеров.

Именно поэтому поведение Яндекса выглядит очень странным.

Является ли ИКС Яндекса ИКСПЯ?

Теперь включаем логику. Допустим, Яндекс не интересуют дополнительные деньги. Допустим, Яндекс ввел ИКС и сделал его общедоступным просто из-за любви к искусству, чтобы показать всем силу своего интеллекта, и не более.

Давайте теперь думать, как Яндекс и рассуждать как Яндекс в модели честного объективного Яндекса, для которого все сайты равны.

ИКС и вовлеченность сайта в сервисы Яндекса

В этом случае получается, что такие вещи, как установка на сайте Яндекс-Метрики не должна влиять на ИКС сайта. Вообще, участие сайта в разных сервисах Яндекса не должно влиять на его ИКС никоим образом.

Ведь при честном подходе и равном отношении ко всем сайтам, учет данных Метрики на одном сайте будет несправедливым по отношению к тому сайту, который не установил у себя Метрику.

Представьте себе, что два сайта имеют одинаковый трафик из поиска Яндекса. Но на одном из этих сайтов стоит Метрика. И она показывает дополнительный очень большой трафик на сайт из поиска Гугла, из социальных сетей и по ссылкам с других сайтов. И этот трафик очень качественный, мало отказов, большое количество просмотренных страниц, большое время пребывания людей на сайте.

Спрашивается, как Яндекс получит те же самые данные по трафику, пришедшему из Гугла, из других сайтов и из соцсетей для того сайта, который не установил у себя Метрику? Если этот сайт, вообще, не зарегистрирован ни в одном сервисе Яндекса? Ни в Яндекс-Справочнике, ни в Яндекс-Дзен, вообще, нигде там, где Яндекс мог бы получить какую-то дополнительную информацию о трафике на этот сайт из других источников трафика, кроме поиска Яндекса.

Многие люди, которые уже продолжительное время находятся в теме SEO, порой уже не представляют, что есть очень много сайтов, на которых Метрика не установлена. Например, на FaceBook не стоит Метрика Яндекса, значит, Яндекс ничего не знает о трафике на какой-нибудь сайт с ФейсБука, если на том сайте не стоит Метрика. Метрика не установлена ни на одном сервисе Гугла. Значит, если на сайте нет Метрики, то Яндекс ничего не знает о трафике на сайт с сервисов Гугла.

Точно также в Рунете есть много сайтов, на которых Метрика тоже не установлена. Поэтому Яндекс ничего не подозревает о трафике между такими сайтами. А этот трафик между такими сайтами может быть не малым по сравнению с трафиком из поиска Яндекса, с учетом того, что хозяева этих сайтов не озабоченные.

Из-за того, что владельцы таких сайтов, как правило, не озабочены, часто эти сайты, с одной стороны, имеют не слишком высокие позиции в поиске из-за своих "грехов", типа отсутствия мобильной версии, отсутствия title и description и т.п. А, с другой стороны, эти сайты могут быть очень популярными из-за очень хороших оригинальных авторских текстов без всякого рерайта. Вы можете найти на таких сайтах то, что не найдёте больше нигде. Их материалы ещё не успели отрерайтить на других сайтах.

Спрашивается, если Яндекс одинаково относится ко всем сайтам при подсчете ИКС, то, как он считает ИКС у таких сайтов, которые не зарегистрированы ни в одном сервисе Яндекса?

Данные для ИКС из поиска Яндекса

Если задуматься над этим, то самый честный вариант подсчета ИКС состоит в уравнивании источников данных для всех сайтов. То есть, если какие-то данные Яндекс может получить только из Метрики и больше никак, то эти данные в расчете ИКС не должны участвовать, ибо непонятно, что в формулу ИСК надо поставлять, когда у Яндекса нет таких данных о сайте.

Таким образом, в модели честного Яндекса получаем, что формальная регистрация своего сайта в сервисах Яндекса ничего не дает в плане увеличения ИКС сайта. Яндекс должен учитывать в формуле ИКС только те данные, которые он может получить со всех сайтов, в том числе и с сайтов, которые не зарегистрированы ни в каком из сервисов Яндекса.

Это такие данные, как:

- контент сайта (тексты, картинки, аудио и видео на сайте), в том числе и метатеги вебстраниц;

- ссылки на сайт (внешние и внутренние, seo или естественные);

- ссылки с сайта на другие сайты, на сколько они уместные и логичные;

- количество страниц сайта;

- трафик на сайт из поиска Яндекса;

- какие страницы сайта получают трафик с поиска Яндекса, а какие нет;

- сколько времени проводит пользователь с поиска Яндекса на сайте, прежде чем вернуться обратно в поиск;

- есть ли мобильная версия сайта;

- сколько времени грузятся страницы сайта;

- какие в Интернете оставлены отзывы про сайт;

- есть ли сообщества в соцсетях, посвященные сайту;

- и т.п.

Все эти данные сайта Яндекс может получить о любом сайте, который принимает участие в поиске Яндекса.

Если сайт неизвестен поисковой системе Яндекса, то ИКС для него не считается. Можете сами проверить это на каком-нибудь очень качественном сайте из американской глубинки, который получает большой трафик с Гугла и Яху.

Нужна ли регистрация в сервисах Яндекса для роста ИКС

Это не значит, что совсем не нужно регистрировать свой сайт в сервисах Яндекса. Речь идет о том, что формальная регистрация в сервисах Яндекса никак не поднимает значение ИКС в модели честного Яндекса.

Другое дело, если такая регистрация будет использована вебмастером с пользой для самого сайта. Например, зарегистрировавшись в Яндекс-Вебмастер можно воспользоваться его сервисом ускорения загрузки мобильных страниц "Турбо-Страницы". Часть страниц сайта будут грузиться быстрее. Это чуть-чуть увеличит значение ИКС, так как, скорее всего, пусть даже и с очень маленьким весовым коэффициентом, но в ИКС должна учитываться средняя скорость загрузки страниц. Все поисковики считают высокую скорость загрузки страниц признаком качества сайта по той причине, что часть пользователей не ждёт окончания загрузки долгогрузящейся страницы и уходит с сайта.

Возможно, именно поэтому некоторые исследователи ИКС наблюдают некоторую корреляцию между величиной ИКС и присутствием сайта в некоторых сервисах Яндекса. Это, скорее всего, в модели честного Яндекса объясняется именно тем, что вебмастера этих сайтов воспользовались информацией этих сервисов для улучшения своего сайта.

То же самое, что и о сервисах Яндекса, можно сказать и об асессорах Яндекса и его толокнянах. В рамках модели честного Яндекса оценки асессоров и толокнян не должны влиять на ИКС сайта, так как таких оценок нет для всех сайтов. Или, по крайней мере, нет оценок асессорами и толокнянами для всех сайтов одновременно за один месяц. (ИКС обещают пересчитывать ежемесячно.)

Итак, в рамках модели честного Яндекса ИКС, на самом деле, является ИКСПЯ, то есть Индекс Качества Сайта в Поисковике Яндекс (или в Поиске Яндекса).

Является ли ИКС Яндекса ИКССЯ?

Но если ИКС является ИКСПЯ, то это никак не объясняет нам, почему всё таки Яндекс сделал информацию об этом индексе открытой. У Гугла, наверняка, есть подобный индекс, но он не распространяет информацию о нем для всех, чтобы не возрождать индустрию продажи ссылок.

Есть другая гипотеза. Это гипотеза о том, что, на самом деле, Яндекс более хитрый, чем честный.

В рамках модели хитрого Яндекса ИКС является не ИКСПЯ, а ИКССЯ, то есть Индекс Качества Сайта в Сервисах Яндекса. (Уловили разницу между одним сервисом Яндекса, который поиск, и всеми другими сервисами Яндекса?)

Подозрения относительно ИКС

Да есть такое подозрение и оно очень сильное. На некоторую корреляцию между величиной ИКС и вовлеченность сайта в сервисы Яндекса (Директ, Справочник и др.) первыми обратили внимание некоторые форумчане на SearchEngines уже в первый день после появления ИКС в открытом виде.

В блоге сервиса 1PS об этом говорится чуть ли не как о доказанном факте: "В учет идут все сервисы Яндекса - от Дзена до Яндекс.Карт. И теперь вы просто обязаны во все эти сервисы попасть...". В статье ссылаются на то, что Яндекс в своём сообщении об ИКС прямо указывает, что информацию о сайтах он берет из своих сервисов (во множественном числе, а не в единственном) и что он хочет этим индексом оценивать даже полезность бизнеса, стоящего за сайтом, для пользователей Интернета. Такая полезность для пользователей Интернета во многом оценивается именно через сервисы Яндекса.

Или, например, на сайте МегаИндекс автор статьи про ИКС и три комментатора говорят о том, что на величину ИКС оказывает влияние type-in трафик. То есть такой трафик, когда посетитель сайта не переходит на сайт по ссылке, а сам вбивает доменное имя сайта в строку браузера. Но сведения про такой трафик Яндекс может получить только или если на сайте установлена Яндекс-Метрика, или если посетитель сайта сидит в Яндекс-Браузере.

Есть много других примеров, которые усиливают подозрение, что Яндекс при вычислении ИКС использует такие данные своих сервисов, которые нельзя получить без этих сервисов. Если это так, то спрашивается, что подставляется в формулу ИКС при вычислении ИКС для сайтов, которые не зарегистрированы в сервисах Яндекса?

Тут два варианта.

Эвристика или наказание

Или в формулу вычисления ИКС подставляется "средняя температура по больнице" или сайты, не зарегистрированные в сервисах Яндекса (или зарегистрированные в маленьком числе этих сервисов), получают пенальти от Яндекса в виде понижения их ИКС (за свою скрытность).

Первый вариант представляется очень маловероятным. Слишком велика дисперсия "температуры по больнице". Всякий, кто раскручивал не один, а несколько сайтов знают, что органический трафик от Гугла и Яндекса могут быть одинаковыми, а могут различаться более чем в 5 раз в ту или другую сторону. Из соцсетей трафика на сайт может не быть совсем, а может этот трафик составлять более 80% от всего трафика на сайт.

Поэтому подстановка "средней температуры по больнице" в формулу ИКС может привести к грандиозным ошибкам в величине ИКС для сайтов, которые не зарегистрированы в сервисах Яндекса или зарегистрированы в маленьком количестве этих сервисов.

Хотя тут всё снова упирается в цели Яндекса. Возможно, Яндексу наплевать на такие сильные неточности в вычислении ИКС. Может для Яндекса важен только сам факт того, что есть такая пузомерка, значение которой может обозревать сеошная публика. А может быть сайтов, которые не установили у себя Метрику и не зарегистрированы в паре сервисов Яндекса, уже так мало, что Яндексу наплевать на этот маленький процент таких сайтов. Возможно, динамика такова, что Яндекс прогнозирует, что через 5 лет таких сайтов уже не будет. Тут разные могут быть причины того, что Яндекс может сознательно неправильно вычислять ИКС некоторых сайтов.

Но всё таки мне кажется, что вариант "средней температуры по больнице" в модели хитрого Яндекса менее вероятен, чем вариант низкого ИКС для "еретиков", пренебрегающих "храмами" Яндекса.

Цель Яндекса

Яндекс своим публичным ИКС, как бы, даёт понять веб-мастерам, в каких "храмах" надо присутствовать (и кому "молиться"). Как минимум, Яндекс желал бы, чтобы все сайты Рунета были бы зарегистрированы в Яндекс-Вебмастер и установили бы у себя Метрику. А, как максимум, чтобы все сайты ещё были бы зарегистрированы минимум десятке других сервисов Яндекса. В первую очередь, в таких сервисах, как Директ, Справочник, Карты, Деньги, Касса, Аудитории, Реклама, Маркет, Доставка и в подобных сервисах, предназначенных для ведения бизнеса.

В результате Яндекс идет по пути создания мифа о том, что присутствие сайта в сервисах Яндекса каким-то образом влияет на отношение Яндекса к сайту. (Ну, наверное, действительно влияет на отношение, но не на позиции в поисковой выдаче.) Причем, этот миф создается не столько Яндексом, сколько SEO-сообществом, их исследованиями пузомерки ИКС. А дело Яндекса, это всего лишь сделать пузомерку зависимую от участия сайта в сервисах Яндекса и вбросить эту пузомерку в СЕО-сообщество.

Такой способ привлечения вебмастеров в свои сервисы более эффективный, чем просто прямо пригласить их туда. Например, некоторые вебмастера опасаются устанавливать на своих сайтах Метрику по той причине, что считают это методом шпионажа Яндекса за аудиторией сайта. Но они могут изменить своё решение, если одна только установка Метрики повышает трастовость сайта в глазах Яндекса. Они ещё более охотнее сделают это, если поверят, что ИКС как-то влияет на позицию сайта в поиске Яндекса.

Зачем Яндексу это нужно?

Война с Гуглом

Это диктует логика его войны с Гуглом. Яндекс уже несколько лет подряд проигрывает войну Гуглу. Доля русскоязычных поисковых запросов в Гугле растёт, а в Яндексе падает. И Яндекс ничего не может с этим поделать. Стандартные методы конкурентной борьбы не помогают. Гугл владеет этими методами лучше Яндекса.

Проигрыш конкурентной борьбы Гуглу грозит Яндексу потерей доходов от своего самого любимого источника доходов, от Директа. Просто ситуация может обернуться даже тем, что если не показывать никакой пузомерки SEO-сообществу и убить рынок продажных ссылок, то все покупатели продажных ссылок окажутся не в Директе, а в ЭдВордсе. В общем, потеря доходов от индустрии продажи ссылок для Яндекса не такая большая, как общая потеря доходов от поражения в конкурентной борьбе с Гуглом.

Сильная сторона Гугла, это его многочисленные сервисы, благодаря которым Гугл очень хорошо знает аудиторию Интернете, в том числе и аудиторию Рунета. Яндексу просто необходимо вовлечь свою аудиторию в свои сервисы как можно больше, чтобы как следует изучить её и её потребности.

Особенно важным для Яндекса является присутствие в его сервисах сайтов, за которыми стоит какой-то реальный бизнес. Ибо это очень платежеспособная аудитория. Её и её потребности нужно изучить в первую очередь. Именно поэтому в заявлении Яндекса идут намёки на то, что Яндекс хотел бы с помощью ИКС оценивать не только сами сайты, но и бизнес, стоящий за ними.

Поэтому есть и такая версия про хитрый Яндекс, что ИКС, это на самом деле ИКССЯ. И что вбрасыванием нужной информации в SEO-сообщество, Яндекс пытается манипулировать вовлеченностью сайтов в свои сервисы.

Какая из двух версий (честный Яндекс и ИКСПЯ или хитрый Яндекс и ИКССЯ) более правильная, покажет время.

Вместо заключения

Выводов никаких по этой статье не делаю и вместо заключения просто расскажу о своих наблюдениях значений ИКС.

На своих сайтах заметил только одну корреляцию. ИКС коррелирует с отношением количества трафика с Яндекса к количеству всех страниц в поиске Яндекса.

Примерно это выглядит так. Есть два сайта. На первом посещаемость около 100 в день с поиска Яндекса и количество страниц в индексе Яндекса около 2500. Отношение трафика к числу проиндексированных страниц примерно 0.04. На втором посещаемость около 30 с поиска Яндекса и количество станиц в индексе 42. Отношение трафика к числу проиндексированных страниц тут уже примерно 0.71. При этом ИКС второго сайта на порядок больше, чем ИКС первого сайта.

Кроме того, трафик с поиска Яндекса на первом сайте идет практически только примерно на 120 страниц, то есть около 4% от всех страниц в индексе Яндекса. Все остальные страницы этого сайта для поисковой системы Яндекса являются, как бы, бесполезным ненужным балластом. В то время, как на втором сайте трафик с Яндекса получает примерно 20 страниц, то есть около 50% всех проиндексированных страниц. Возможно, это тоже играет роль при подсчете ИКС.

В любом случае нужно будет посмотреть, можно ли как-то на первом сайте уменьшить число страниц, которые совсем не получают трафик, не только от Яндекса, но и от Гугла и из соцсетей и с других сайтов. Нужно будет решить, как правильно сократить число страниц. Тут три варианта:

- Просто уничтожить страницу.

- Объединить несколько страниц в одну страницу.

- Через файл robots запретить Яндексу индексировать эти страницы.

Если будет какой-то результат, то обязательно напишу об этом.

------------------

Автор статьи: Евгений Миронов.

Сейчас тема раскрутки молодых сайтов очень популярна. На это есть свои причины. В последнее время, чтобы раскрутить недавно созданный сайт (или даже старый сайт, который долгое время был заброшенным) нужно много времени. Сейчас уже не получится купить очень много ссылок и за счет ссылочной массы выйти на первую страницу поисковой выдачи, как это было раньше, например лет 10 назад. Теперь поисковые системы попросту не допускают в топ своей поисковой выдачи такие сайты, которым они не доверяют, которых они не знают или мало знают.

Что же теперь делать новым только что появившимся сайтам? Попробуем разобраться.

Внутренняя оптимизация сайта

Начинать работу по раскрутке молодого сайта в поисковых системах нужно с внутренней оптимизации сайта. Для этого нужно правильно распределить семантическое ядро по страницам сайта. Значит, начинать работу надо с составления первичного семантического ядра. Особенность первичного семантического ядра для новых сайтов состоит в том, что оно должно содержать только низкочастотные и среднечастоные поисковые запросы. Никаких высокочастотников! Основной упор нужно сделать на низкочастотники. Более подробно о составлении семантического ядра можно прочитать тут.